按從左到右的順序依次生成下一個(gè) token 真的是大模型生成方式的最優(yōu)解嗎?最近,越來(lái)越多的研究者對(duì)此提出質(zhì)疑。其中,有些研究者已經(jīng)轉(zhuǎn)向一個(gè)新的方向 —— 掩碼擴(kuò)散語(yǔ)言模型(MDLM)。

和自回歸(AR)語(yǔ)言模型不同,MDLM 的訓(xùn)練目標(biāo)是隨機(jī)遮蔽序列中的若干位置,模型學(xué)習(xí)去 in-fill(填充)這些被遮蔽位置。這樣訓(xùn)練出來(lái)的模型存在諸多優(yōu)勢(shì),如支持任意順序解碼、多 token 并行解碼等。此前有研究表明,MDLM 的這些優(yōu)勢(shì)使其在數(shù)獨(dú)等邏輯謎題上的表現(xiàn)得到顯著提升。

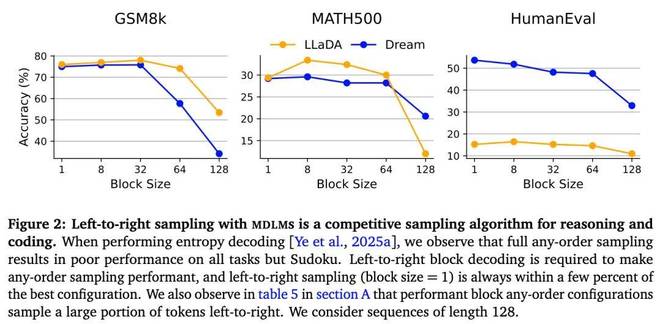

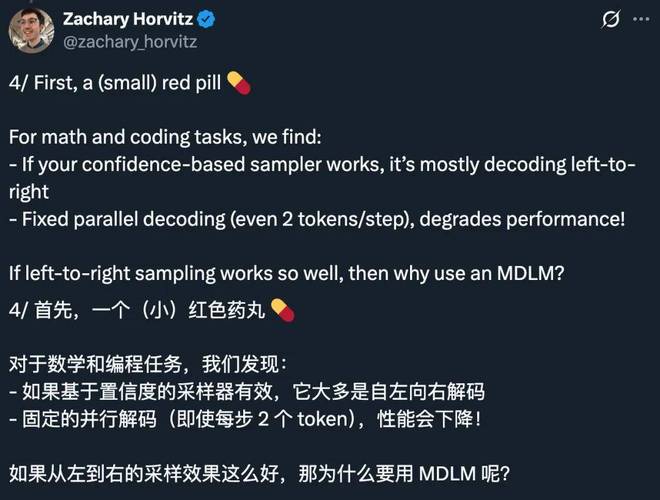

然而,最近的一篇論文有了一些意外發(fā)現(xiàn):在數(shù)學(xué)和編碼任務(wù)中,任意順序算法的性能往往不如從左到右采樣,或者表現(xiàn)與之相似,而標(biāo)準(zhǔn)的多 token 解碼會(huì)顯著降低性能。即使僅在兩個(gè) token 上進(jìn)行并行解碼,模型在主流基準(zhǔn)任務(wù)上的性能也會(huì)顯著下降。

使用 MDLM 進(jìn)行從左到右的采樣是一種適用于推理和編碼的高效采樣算法。如果沒(méi)有 [Arriola et al., 2025] 提出的塊大小(block sizes)來(lái)強(qiáng)制形成半自回歸(AR)的從左到右結(jié)構(gòu),任意順序會(huì)顯著影響性能。

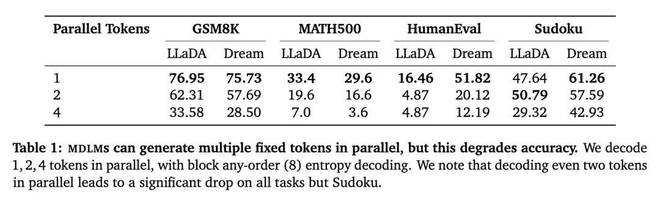

MDLM 能夠并行生成多個(gè)固定 token,但這會(huì)降低準(zhǔn)確性。作者使用塊任意順序熵解碼,并行解碼 1 個(gè)、2 個(gè)、4 個(gè) token。可以看到,除數(shù)獨(dú)外,在所有任務(wù)中,即使并行解碼兩個(gè) token 也會(huì)導(dǎo)致性能顯著下降。

這一結(jié)果引發(fā)了一個(gè)問(wèn)題:既然 MDLM 在訓(xùn)練時(shí)投入了大量額外計(jì)算資源以建模所有被掩碼位置的聯(lián)合分布,那么這些額外的計(jì)算是否真的物有所值?

為了回答這個(gè)問(wèn)題,研究者探究了如何將這些計(jì)算資源重新利用為有意義的推理與采樣能力。他們證明,MDLM 提供了對(duì)所有掩碼位置的條件分布的訪問(wèn)權(quán)限,并具備填充(in-filling)能力,這一特性解鎖了傳統(tǒng) NTP 模型無(wú)法輕易實(shí)現(xiàn)的新型采樣與后訓(xùn)練(post-training)機(jī)制。

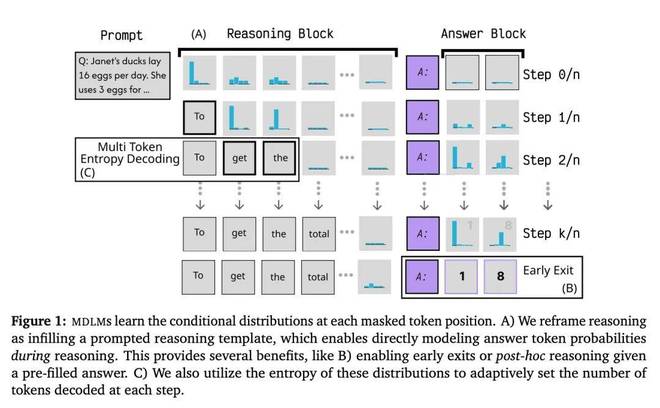

首先,研究者展示了 MDLM 的填充能力如何開(kāi)啟新的模型提示范式。在本文中,他們提出了「提示即填充」(prompting-as-infilling) 的方法。與 NTP 模型僅能在序列起始位置添加提示不同,這種方法允許在多個(gè)位置添加由用戶指定的上下文。

更具體地,他們提出了「推理即填充」(reasoning-as-infilling) 的框架。在該框架中,研究者預(yù)先構(gòu)造了一個(gè)顯式的「推理模板」(reasoning template),其中包含特定的推理位置與答案位置(參見(jiàn)圖 1)。這一模板結(jié)構(gòu)使得模型能夠基于給定的推理預(yù)算和格式,對(duì)推理軌跡進(jìn)行采樣。